人工智能不再仅仅是未来科技的构想,它正在为各行各业的实际人工智能应用提供动力。从诊断疾病到预测金融风险,人工智能正在改变决策方式。但随着这些系统的影响力日益增强,一个挑战依然存在:信任。如果我们不了解结果的产生过程,我们还能相信这些结果吗?正因如此,可解释性对于构建透明的人工智能系统至关重要。.

为什么可解释性在透明人工智能系统中至关重要

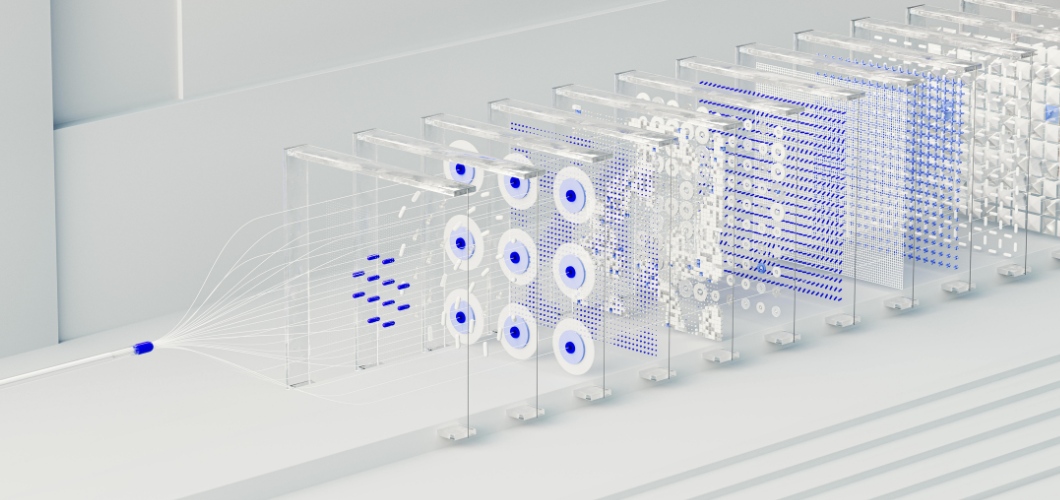

许多先进人工智能解决方案的核心是神经网络,这是一种模仿人脑的系统。虽然神经网络擅长识别模式和做出准确预测,但它们通常被视为“黑箱”。用户很少了解输入如何产生特定输出。这种不透明性会造成犹豫,尤其是在医疗保健、法律或金融等高风险领域。要使人工智能透明且符合伦理,可解释性必须放在首位。.

提高神经网络可解释性的策略

可视化技术

显著性图和注意力热图等工具可以突出显示哪些数据点影响了神经网络的决策,从而提供更清晰的信息。.

事后分析

SHAP(SHapley 加性解释)和 LIME(局部可解释模型无关解释)等方法将预测分解为可理解的因素,帮助用户跟踪输出。.

简化的混合模型

将神经网络与可解释模型(例如决策树)相结合,可以让企业在复杂性和可读性之间取得平衡。.

特征重要性跟踪

通过识别哪些变量最具影响力,组织可以验证结果并检测人工智能应用中的潜在偏差。.

通过透明度建立信任

透明的人工智能系统不仅关乎合规性,更关乎信任的建立。当企业采用可解释的人工智能实践时,用户会更愿意信赖其结果。透明度还有助于减少偏见、确保问责制,并支持合乎道德的决策。简而言之,可解释性能够增强人们对技术本身及其部署组织的信任。.

透明人工智能系统的未来

随着人工智能的不断发展,可解释性将在其成长过程中扮演核心角色。监管机构要求透明度,消费者期望公平性。投资于可解释神经网络的组织不仅能够满足这些要求,还能在负责任的创新领域脱颖而出,成为行业领导者。.