인공지능은 더 이상 미래의 개념에 그치지 않고, 다양한 산업 분야에서 실제 AI 애플리케이션을 구동하고 있습니다. 질병 진단부터 금융 위험 예측에 이르기까지, AI는 의사 결정 방식을 혁신하고 있습니다. 하지만 이러한 시스템의 영향력이 커질수록 한 가지 과제가 남습니다. 바로 신뢰입니다. 결과가 어떻게 도출되었는지 이해하지 못한다면 과연 그 결과를 신뢰할 수 있을까요? 투명한 AI 시스템을 구축하는 데 있어 설명 가능성은 매우 중요한 요소입니다.

투명한 AI 시스템에서 설명 가능성이 중요한 이유

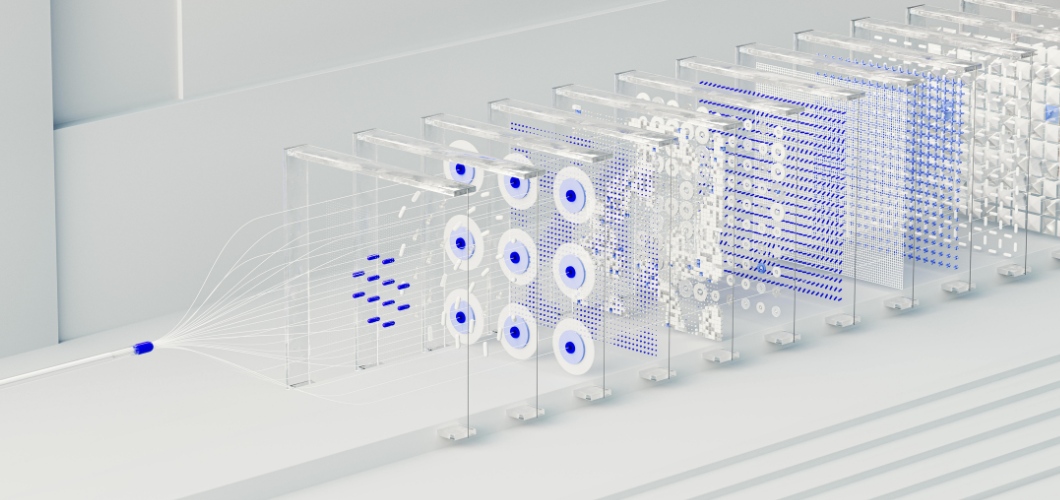

많은 첨단 AI 솔루션의 핵심에는 인간의 뇌를 본뜬 신경망 시스템이 있습니다. 신경망은 패턴을 감지하고 정확한 예측을 하는 데 탁월하지만, 종종 "블랙박스"로 여겨집니다. 사용자는 입력값이 특정 출력값으로 이어지는 과정을 거의 알 수 없습니다. 이러한 불투명성은 특히 의료, 법률, 금융과 같이 위험 부담이 큰 분야에서 사용자에게 주저함을 유발할 수 있습니다. AI가 투명하고 윤리적으로 작동하려면 설명 가능성을 최우선으로 고려해야 합니다.

관련 기사: AI가 생성한 예술 작품은 인간 창의성의 가치를 떨어뜨리는가?

신경망 설명력 향상을 위한 전략

시각화 기법

살리언시 맵이나 어텐션 히트맵과 같은 도구는 어떤 데이터 포인트가 신경망의 결정에 영향을 미쳤는지 강조하여 더 명확한 정보를 제공합니다.

사후 분석

SHAP(SHapley Additive Explanations) 및 LIME(Local Interpretable Model-agnostic Explanations)과 같은 방법은 예측 결과를 이해하기 쉬운 요소로 분해하여 사용자가 출력 결과를 추적할 수 있도록 도와줍니다.

단순화된 하이브리드 모델

신경망을 의사결정 트리와 같은 해석 가능한 모델과 결합하면 기업은 복잡성과 가독성 사이의 균형을 맞출 수 있습니다.

기능 중요도 추적

조직은 어떤 변수가 가장 큰 영향을 미치는지 파악함으로써 결과를 검증하고 AI 애플리케이션 내의 잠재적 편향을 감지할 수 있습니다.

투명성을 통한 신뢰 구축

투명한 AI 시스템은 단순히 규정 준수만을 위한 것이 아니라, 신뢰 구축의 핵심입니다. 기업이 설명 가능한 AI 방식을 도입하면 사용자는 결과에 더욱 안심하고 의존할 수 있습니다. 투명성은 편견을 줄이고, 책임성을 확보하며, 윤리적인 의사결정을 지원합니다. 요컨대, 설명 가능성은 기술과 이를 도입하는 조직 모두에 대한 신뢰를 강화합니다.

투명한 AI 시스템의 미래

인공지능이 계속 발전함에 따라 설명 가능성은 성장에 있어 핵심적인 역할을 할 것입니다. 규제 기관은 명확성을 요구하고 있으며, 소비자는 공정성을 기대하고 있습니다. 설명 가능한 신경망에 투자하는 기업은 이러한 요구 사항을 충족할 뿐만 아니라 책임 있는 혁신의 선두 주자로서 차별화된 모습을 보여줄 수 있을 것입니다.