A inteligência artificial deixou de ser apenas uma ideia futurista — ela está impulsionando aplicações reais de IA em diversos setores. Do diagnóstico de doenças à previsão de riscos financeiros, a IA está mudando a forma como as decisões são tomadas. Mas, à medida que esses sistemas se tornam mais influentes, um desafio persiste: a confiança. Podemos confiar nos resultados se não entendermos como eles foram produzidos? É aqui que a explicabilidade se torna crucial para a construção de sistemas de IA transparentes.

Por que a explicabilidade é importante em sistemas de IA transparentes

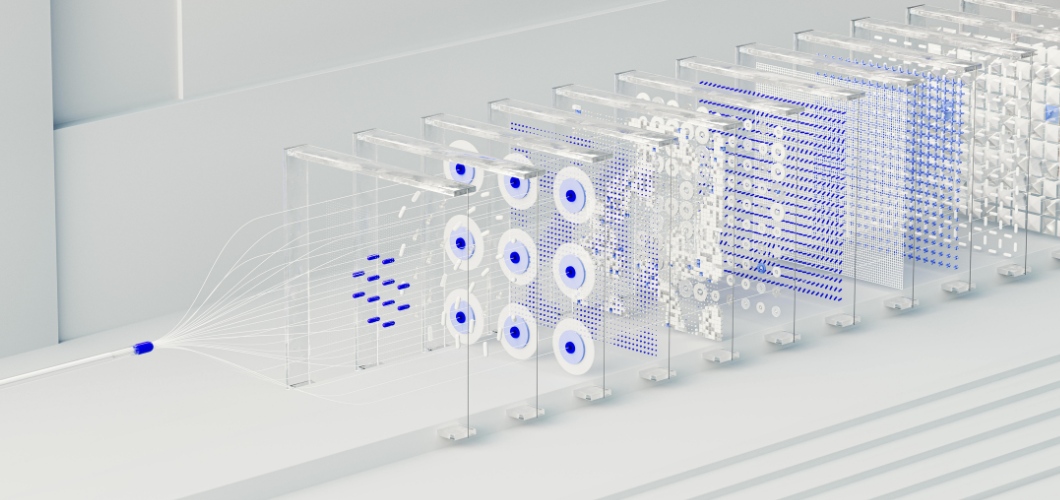

No cerne de muitas soluções avançadas de IA está a rede neural, um sistema modelado a partir do cérebro humano. Embora as redes neurais sejam excelentes na detecção de padrões e na realização de previsões precisas, elas são frequentemente vistas como "caixas-pretas". Os usuários raramente sabem como uma entrada leva a uma determinada saída. Essa falta de visibilidade pode gerar hesitação, especialmente em áreas de alto risco como saúde, direito ou finanças. Para que a IA seja transparente e ética, a explicabilidade deve ser priorizada.

Leia também: A arte gerada por IA diminui o valor da criatividade humana?

Estratégias para melhorar a explicabilidade das redes neurais

Técnicas de visualização

Ferramentas como mapas de saliência e mapas de calor de atenção destacam quais pontos de dados influenciaram as decisões da rede neural, oferecendo maior clareza.

Análise Post-Hoc

Métodos como SHAP (SHapley Additive Explanations) e LIME (Local Interpretable Model-agnostic Explanations) decompõem as previsões em fatores compreensíveis, ajudando os usuários a rastrear os resultados.

Modelos híbridos simplificados

A combinação de redes neurais com modelos interpretáveis, como árvores de decisão, permite que as empresas equilibrem a complexidade com a legibilidade.

Rastreamento da importância das funcionalidades

Ao identificar quais variáveis são mais influentes, as organizações podem validar resultados e detectar possíveis vieses em aplicações de IA.

Construindo confiança através da transparência

Sistemas de IA transparentes não se resumem apenas ao cumprimento de regulamentações — eles também visam construir confiança. Quando as empresas adotam práticas de IA explicáveis, os usuários se sentem mais seguros ao confiar nos resultados. A transparência também ajuda a reduzir vieses, garante a responsabilização e apoia a tomada de decisões éticas. Em resumo, a explicabilidade fortalece a confiança tanto na tecnologia quanto na organização que a implementa.

O futuro dos sistemas de IA transparentes

À medida que a IA continua a evoluir, a explicabilidade desempenhará um papel central em seu crescimento. Os órgãos reguladores exigem clareza e os consumidores esperam imparcialidade. As organizações que investirem em redes neurais explicáveis não apenas atenderão a esses requisitos, mas também se destacarão como líderes em inovação responsável.