人工知能はもはや単なる未来的なアイデアではなく、あらゆる業界で現実世界のAIアプリケーションを支えています。病状の診断から金融リスクの予測まで、AIは意思決定の方法を変えつつあります。しかし、これらのシステムの影響力が高まるにつれて、一つの課題が残ります。それは信頼です。結果がどのように生成されたかを理解できなければ、信頼できるでしょうか?透明性のあるAIシステムを構築するには、説明可能性が重要になります。.

透明なAIシステムにおいて説明可能性が重要な理由

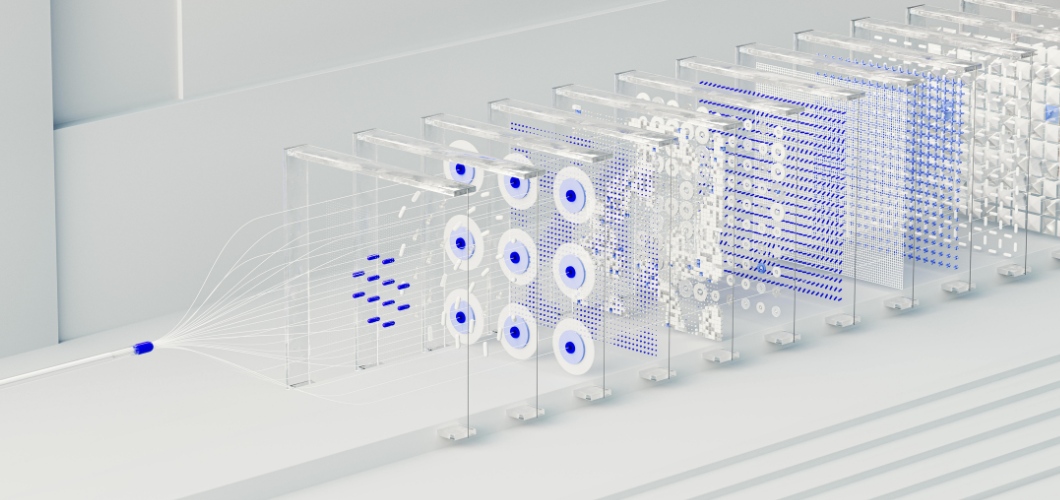

多くの高度なAIソリューションの中核を成すのは、人間の脳をモデルにしたニューラルネットワークです。ニューラルネットワークはパターン検出と正確な予測に優れていますが、しばしば「ブラックボックス」と見なされます。ユーザーは、入力がどのように特定の出力につながるのかをほとんど理解できません。この可視性の欠如は、特に医療、法律、金融といったハイリスクな分野では、導入をためらわせる要因となります。AIの透明性と倫理性を確保するには、説明可能性を最優先に考える必要があります。.

こちらもお読みください: AI生成アートは人間の創造性の価値を低下させるのか

ニューラルネットワークの説明可能性を向上させる戦略

視覚化技術

サリエンシーマップやアテンションヒートマップなどのツールは、ニューラルネットワークの決定に影響を与えたデータポイントを強調表示し、より明確にします。.

事後分析

SHAP (SHapley Additive Explains) や LIME (Local Interpretable Model-agnostic Explains) などの方法は、予測を理解可能な要素に分解し、ユーザーが出力を追跡できるようにします。.

簡素化されたハイブリッドモデル

ニューラル ネットワークを意思決定ツリーなどの解釈可能なモデルと組み合わせることで、企業は複雑さと読みやすさのバランスをとることができます。.

特徴重要度の追跡

最も影響力のある変数を特定することで、組織は結果を検証し、AI アプリケーション内の潜在的なバイアスを検出できます。.

透明性を通じて信頼を築く

透明性の高いAIシステムは、規制遵守だけでなく、信頼の構築にもつながります。企業が説明可能なAIの実践を導入すると、ユーザーは結果に安心して信頼を置くことができます。透明性は、バイアスの低減、説明責任の確保、そして倫理的な意思決定の支援にも役立ちます。つまり、説明可能性は、テクノロジーとそれを導入する組織の両方に対する信頼を強化するのです。.

透明なAIシステムの未来

AIが進化を続ける中で、説明可能性はAIの成長において中心的な役割を果たすでしょう。規制当局は透明性を求め、消費者は公平性を期待しています。説明可能なニューラルネットワークに投資する組織は、これらの要件を満たすだけでなく、責任あるイノベーションのリーダーとして際立つ存在となるでしょう。.