L'intelligenza artificiale non è più solo un'idea futuristica: sta alimentando applicazioni di intelligenza artificiale nel mondo reale in diversi settori. Dalla diagnosi di patologie mediche alla previsione dei rischi finanziari, l'intelligenza artificiale sta cambiando il modo in cui vengono prese le decisioni. Ma con l'aumentare dell'influenza di questi sistemi, rimane una sfida: la fiducia. Possiamo fare affidamento sui risultati se non comprendiamo come sono stati prodotti? È qui che la spiegabilità diventa fondamentale per la creazione di sistemi di intelligenza artificiale trasparenti.

Perché la spiegabilità è importante nei sistemi di intelligenza artificiale trasparenti

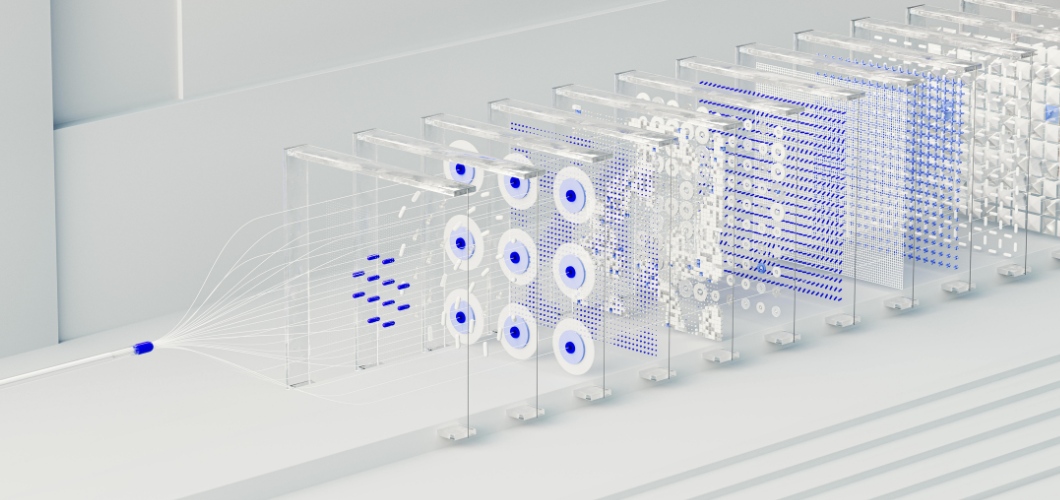

Al centro di molte soluzioni di intelligenza artificiale avanzate c'è la rete neurale, un sistema modellato sul cervello umano. Sebbene le reti neurali eccellano nell'individuazione di pattern e nella formulazione di previsioni accurate, sono spesso viste come "scatole nere". Gli utenti raramente sanno come un input porti a un particolare output. Questa mancanza di visibilità può creare esitazione, soprattutto in settori ad alto rischio come la sanità, il diritto o la finanza. Affinché l'intelligenza artificiale sia trasparente ed etica, la spiegabilità deve essere prioritaria.

Leggi anche: L'arte generata dall'intelligenza artificiale diminuisce il valore della creatività umana?

Strategie per migliorare la spiegabilità delle reti neurali

Tecniche di visualizzazione

Strumenti come le mappe di salienza e le mappe di calore dell'attenzione evidenziano quali punti dati hanno influenzato le decisioni della rete neurale, offrendo maggiore chiarezza.

Analisi post-hoc

Metodi come SHAP (SHapley Additive Explanations) e LIME (Local Interpretable Model-agnostic Explanations) scompongono le previsioni in fattori comprensibili, aiutando gli utenti a tracciare i risultati.

Modelli ibridi semplificati

Combinando reti neurali con modelli interpretabili, come gli alberi decisionali, le aziende possono bilanciare complessità e leggibilità.

Monitoraggio dell'importanza delle funzionalità

Identificando le variabili più influenti, le organizzazioni possono convalidare i risultati e rilevare potenziali distorsioni nelle applicazioni di intelligenza artificiale.

Costruire fiducia attraverso la trasparenza

I sistemi di intelligenza artificiale trasparenti non riguardano solo la conformità alle normative, ma anche la creazione di fiducia. Quando le aziende adottano pratiche di intelligenza artificiale spiegabili, gli utenti si sentono più a loro agio nell'affidarsi ai risultati. La trasparenza contribuisce inoltre a ridurre i pregiudizi, garantisce la responsabilità e supporta un processo decisionale etico. In breve, la spiegabilità rafforza la fiducia sia nella tecnologia che nell'organizzazione che la implementa.

Il futuro dei sistemi di intelligenza artificiale trasparenti

Con la continua evoluzione dell'intelligenza artificiale, la spiegabilità giocherà un ruolo centrale nella sua crescita. Le autorità di regolamentazione esigono chiarezza e i consumatori si aspettano equità. Le organizzazioni che investono in reti neurali spiegabili non solo soddisferanno questi requisiti, ma si distingueranno anche come leader nell'innovazione responsabile.