Kecerdasan buatan bukan lagi sekadar ide futuristik—ia kini mendukung aplikasi AI di dunia nyata di berbagai industri. Dari mendiagnosis kondisi medis hingga memprediksi risiko keuangan, AI mengubah cara pengambilan keputusan. Namun, seiring sistem ini menjadi semakin berpengaruh, satu tantangan tetap ada: kepercayaan. Dapatkah kita mengandalkan hasilnya jika kita tidak memahami bagaimana hasil tersebut dihasilkan? Di sinilah kemampuan menjelaskan menjadi sangat penting untuk membangun sistem AI yang transparan.

Mengapa Kemampuan Menjelaskan Penting dalam Sistem AI Transparan

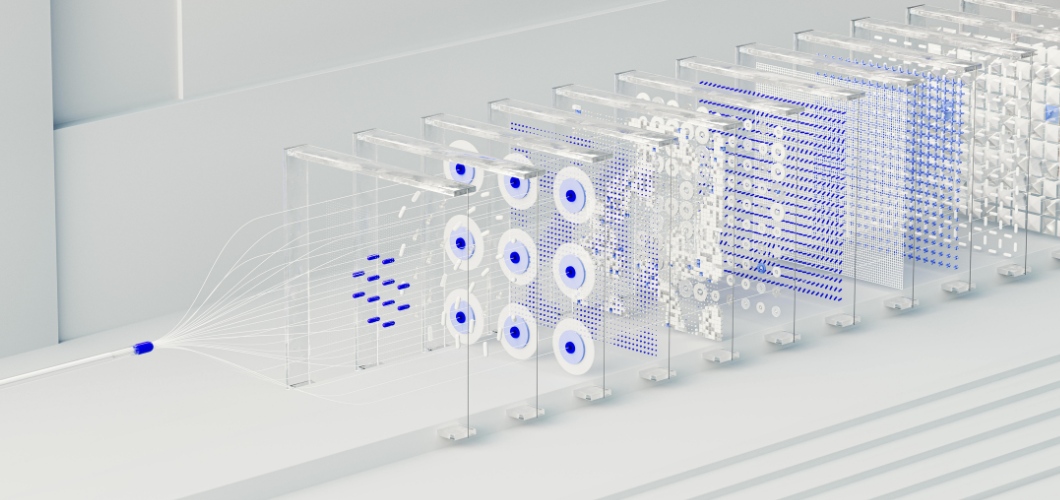

Inti dari banyak solusi AI canggih terletak pada jaringan saraf, sebuah sistem yang dimodelkan berdasarkan otak manusia. Meskipun jaringan saraf unggul dalam mendeteksi pola dan membuat prediksi yang akurat, jaringan saraf sering dianggap sebagai "kotak hitam." Pengguna jarang mengetahui bagaimana suatu input mengarah ke output tertentu. Kurangnya visibilitas ini dapat menimbulkan keraguan, terutama di bidang-bidang yang berisiko tinggi seperti perawatan kesehatan, hukum, atau keuangan. Agar AI transparan dan etis, kemampuan menjelaskan harus diprioritaskan.

Baca Juga: Apakah Seni yang Dihasilkan AI Mengurangi Nilai Kreativitas Manusia?

Strategi untuk Meningkatkan Kemampuan Penjelasan Jaringan Saraf Tiruan

Teknik Visualisasi

Alat-alat seperti peta saliensi dan peta panas perhatian menyoroti titik data mana yang memengaruhi keputusan jaringan saraf, sehingga memberikan kejelasan yang lebih besar.

Analisis Post-Hoc

Metode seperti SHAP (SHapley Additive Explanations) dan LIME (Local Interpretable Model-agnostic Explanations) menguraikan prediksi menjadi faktor-faktor yang mudah dipahami, membantu pengguna melacak output.

Model Hibrida yang Disederhanakan

Menggabungkan jaringan saraf dengan model yang mudah dipahami, seperti pohon keputusan, memungkinkan bisnis untuk menyeimbangkan kompleksitas dengan keterbacaan.

Pelacakan Pentingnya Fitur

Dengan mengidentifikasi variabel mana yang paling berpengaruh, organisasi dapat memvalidasi hasil dan mendeteksi potensi bias dalam aplikasi AI.

Membangun Kepercayaan Melalui Transparansi

Sistem AI yang transparan bukan hanya tentang kepatuhan terhadap peraturan—tetapi juga tentang membangun kepercayaan. Ketika bisnis mengadopsi praktik AI yang dapat dijelaskan, pengguna merasa lebih nyaman mengandalkan hasilnya. Transparansi juga membantu mengurangi bias, memastikan akuntabilitas, dan mendukung pengambilan keputusan yang etis. Singkatnya, kemampuan menjelaskan memperkuat kepercayaan baik pada teknologi maupun organisasi yang menerapkannya.

Masa Depan Sistem AI Transparan

Seiring terus berkembangnya AI, kemampuan menjelaskan akan memainkan peran sentral dalam pertumbuhannya. Regulator menuntut kejelasan, dan konsumen mengharapkan keadilan. Organisasi yang berinvestasi dalam jaringan saraf yang dapat dijelaskan tidak hanya akan memenuhi persyaratan ini tetapi juga membedakan diri sebagai pemimpin dalam inovasi yang bertanggung jawab.