L'intelligence artificielle n'est plus une simple idée futuriste : elle est désormais au cœur d'applications concrètes dans de nombreux secteurs. Du diagnostic médical à la prédiction des risques financiers, l'IA transforme la prise de décision. Mais à mesure que ces systèmes gagnent en influence, un défi majeur demeure : la confiance. Peut-on se fier aux résultats si l'on ne comprend pas comment ils ont été obtenus ? C'est là que l'explicabilité devient essentielle pour concevoir des systèmes d'IA transparents.

Pourquoi l'explicabilité est importante dans les systèmes d'IA transparents

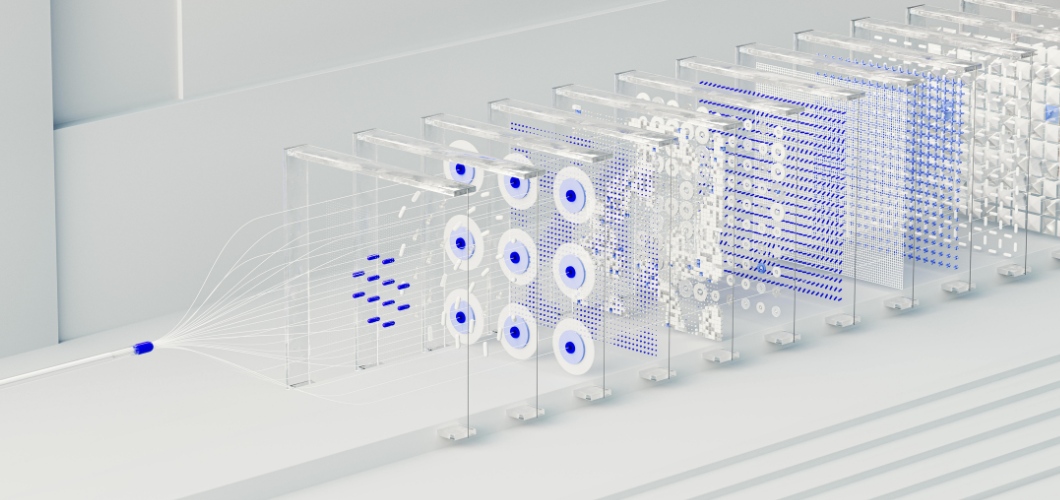

Au cœur de nombreuses solutions d'IA avancées se trouve le réseau neuronal, un système inspiré du cerveau humain. Si les réseaux neuronaux excellent dans la détection de schémas et la réalisation de prédictions précises, ils sont souvent perçus comme des « boîtes noires ». Les utilisateurs ignorent généralement comment une entrée conduit à une sortie particulière. Ce manque de visibilité peut engendrer des hésitations, notamment dans des secteurs à forts enjeux comme la santé, le droit ou la finance. Pour que l'IA soit transparente et éthique, l'explicabilité doit être une priorité.

À lire également : L’art généré par l’IA diminue-t-il la valeur de la créativité humaine ?

Stratégies pour améliorer l'explicabilité des réseaux neuronaux

Techniques de visualisation

Des outils comme les cartes de saillance et les cartes thermiques d'attention mettent en évidence les points de données qui ont influencé les décisions du réseau neuronal, offrant ainsi une plus grande clarté.

Analyse post-hoc

Des méthodes telles que SHAP (SHapley Additive Explanations) et LIME (Local Interpretable Model-agnostic Explanations) décomposent les prédictions en facteurs compréhensibles, aidant ainsi les utilisateurs à suivre les résultats.

Modèles hybrides simplifiés

L'association de réseaux neuronaux à des modèles interprétables, tels que les arbres de décision, permet aux entreprises d'équilibrer complexité et lisibilité.

Suivi de l'importance des fonctionnalités

En identifiant les variables les plus influentes, les organisations peuvent valider les résultats et détecter les biais potentiels au sein des applications d'IA.

Instaurer la confiance par la transparence

Les systèmes d'IA transparents ne se limitent pas à la conformité réglementaire ; ils contribuent aussi à instaurer la confiance. Lorsque les entreprises adoptent des pratiques d'IA explicables, les utilisateurs se sentent plus à l'aise avec les résultats. La transparence permet également de réduire les biais, garantit la responsabilité et favorise une prise de décision éthique. En bref, l'explicabilité renforce la confiance dans la technologie et dans l'organisation qui la déploie.

L'avenir des systèmes d'IA transparents

À mesure que l'IA évolue, l'explicabilité jouera un rôle central dans son développement. Les organismes de réglementation exigent de la transparence et les consommateurs attendent de l'équité. Les organisations qui investissent dans des réseaux neuronaux explicables répondront non seulement à ces exigences, mais se distingueront également comme des chefs de file de l'innovation responsable.