La inteligencia artificial ya no es solo una idea futurista; impulsa aplicaciones de IA en el mundo real en diversos sectores. Desde el diagnóstico de enfermedades hasta la predicción de riesgos financieros, la IA está cambiando la forma en que se toman las decisiones. Pero a medida que estos sistemas se vuelven más influyentes, persiste un desafío: la confianza. ¿Podemos confiar en los resultados si no entendemos cómo se produjeron? Aquí es donde la explicabilidad se vuelve crucial para construir sistemas de IA transparentes.

Por qué es importante la explicabilidad en los sistemas de IA transparentes

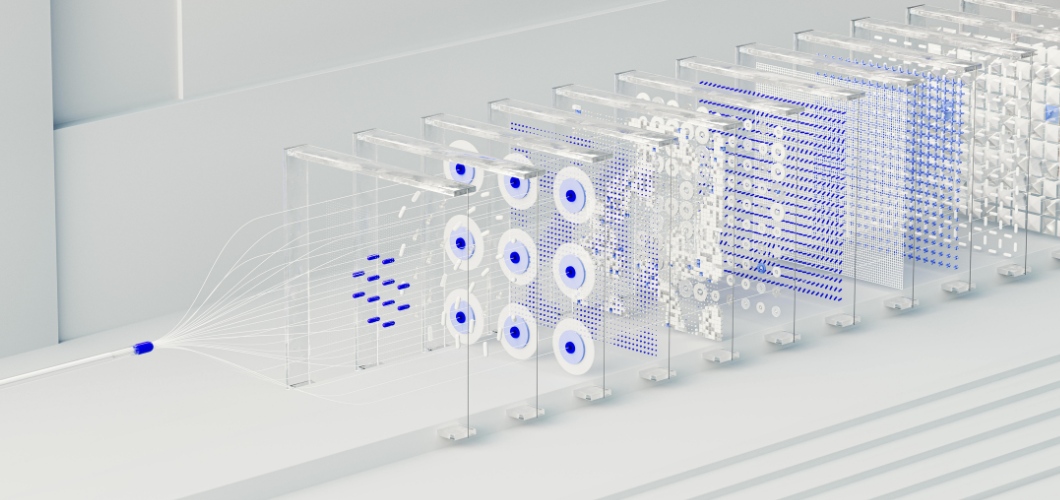

En el núcleo de muchas soluciones avanzadas de IA se encuentra la red neuronal, un sistema basado en el cerebro humano. Si bien las redes neuronales destacan por detectar patrones y realizar predicciones precisas, a menudo se las considera "cajas negras". Los usuarios rara vez saben cómo una entrada conduce a una salida específica. Esta falta de visibilidad puede generar dudas, especialmente en áreas de gran importancia como la salud, el derecho o las finanzas. Para que la IA sea transparente y ética, se debe priorizar la explicabilidad.

Lea también: ¿El arte generado por IA disminuye el valor de la creatividad humana?

Estrategias para mejorar la explicabilidad de las redes neuronales

Técnicas de visualización

Herramientas como los mapas de saliencia y los mapas de calor de atención resaltan qué puntos de datos influyeron en las decisiones de la red neuronal, ofreciendo más claridad.

Análisis post-hoc

Métodos como SHAP (Explicaciones aditivas de SHapley) y LIME (Explicaciones agnósticas del modelo interpretable local) descomponen las predicciones en factores comprensibles, lo que ayuda a los usuarios a rastrear los resultados.

Modelos híbridos simplificados

La combinación de redes neuronales con modelos interpretables, como árboles de decisión, permite a las empresas equilibrar la complejidad con la legibilidad.

Seguimiento de la importancia de las funciones

Al identificar qué variables son más influyentes, las organizaciones pueden validar los resultados y detectar posibles sesgos dentro de las aplicaciones de IA.

Generar confianza a través de la transparencia

Los sistemas de IA transparentes no solo se centran en el cumplimiento normativo, sino también en generar confianza. Cuando las empresas adoptan prácticas de IA explicables, los usuarios se sienten más cómodos al confiar en los resultados. La transparencia también ayuda a reducir los sesgos, garantiza la rendición de cuentas y apoya la toma de decisiones ética. En resumen, la explicabilidad fortalece la confianza tanto en la tecnología como en la organización que la implementa.

El futuro de los sistemas de IA transparentes

A medida que la IA continúa evolucionando, la explicabilidad desempeñará un papel fundamental en su crecimiento. Los reguladores exigen claridad y los consumidores esperan equidad. Las organizaciones que inviertan en redes neuronales explicables no solo cumplirán estos requisitos, sino que también se distinguirán como líderes en innovación responsable.