Künstliche Intelligenz ist längst keine Zukunftsvision mehr – sie treibt reale KI-Anwendungen in verschiedensten Branchen voran. Von der Diagnose von Krankheiten bis zur Prognose finanzieller Risiken verändert KI die Art und Weise, wie Entscheidungen getroffen werden. Doch mit zunehmendem Einfluss dieser Systeme bleibt eine Herausforderung bestehen: Vertrauen. Können wir den Ergebnissen vertrauen, wenn wir nicht verstehen, wie sie zustande gekommen sind? Hier wird Erklärbarkeit entscheidend für die Entwicklung transparenter KI-Systeme.

Warum Erklärbarkeit in transparenten KI-Systemen wichtig ist

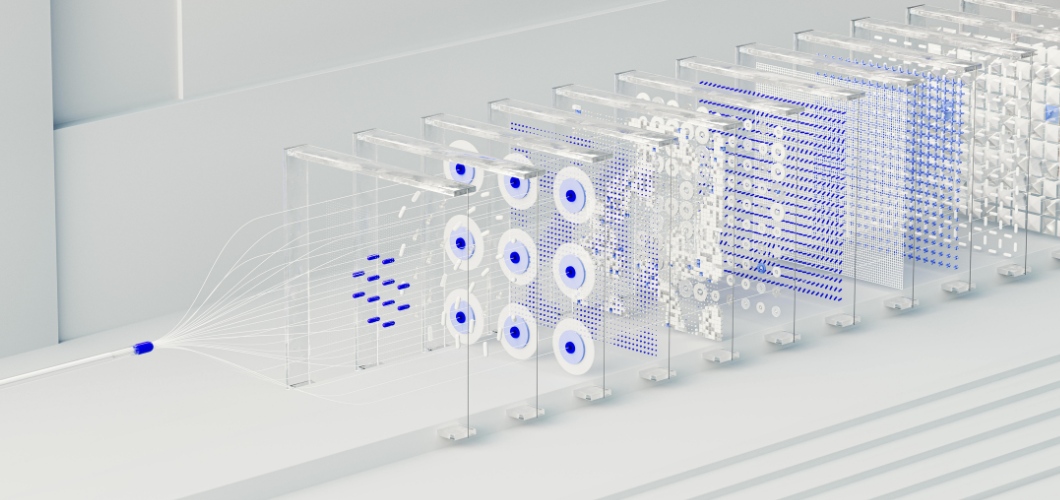

Das Herzstück vieler fortschrittlicher KI-Lösungen bildet das neuronale Netzwerk, ein System, das dem menschlichen Gehirn nachempfunden ist. Obwohl neuronale Netzwerke hervorragend darin sind, Muster zu erkennen und präzise Vorhersagen zu treffen, werden sie oft als „Black Boxes“ betrachtet. Nutzer wissen selten, wie eine Eingabe zu einer bestimmten Ausgabe führt. Diese Intransparenz kann insbesondere in sensiblen Bereichen wie dem Gesundheitswesen, dem Rechtswesen oder dem Finanzsektor zu Bedenken führen. Damit KI transparent und ethisch vertretbar ist, muss die Erklärbarkeit höchste Priorität haben.

Lesen Sie auch: Vermindert KI-generierte Kunst den Wert menschlicher Kreativität?

Strategien zur Verbesserung der Erklärbarkeit neuronaler Netze

Visualisierungstechniken

Tools wie Saliency Maps und Attention Heatmaps heben hervor, welche Datenpunkte die Entscheidungen des neuronalen Netzwerks beeinflusst haben, und sorgen so für mehr Klarheit.

Post-hoc-Analyse

Methoden wie SHAP (SHapley Additive Explanations) und LIME (Local Interpretable Model-agnostic Explanations) zerlegen Vorhersagen in verständliche Faktoren und helfen den Nutzern so, die Ergebnisse nachzuvollziehen.

Vereinfachte Hybridmodelle

Die Kombination neuronaler Netze mit interpretierbaren Modellen, wie beispielsweise Entscheidungsbäumen, ermöglicht es Unternehmen, Komplexität und Lesbarkeit in Einklang zu bringen.

Feature-Wichtigkeitsverfolgung

Durch die Identifizierung der einflussreichsten Variablen können Organisationen Ergebnisse validieren und potenzielle Verzerrungen in KI-Anwendungen aufdecken.

Vertrauen durch Transparenz schaffen

Transparente KI-Systeme dienen nicht nur der Einhaltung von Vorschriften, sondern schaffen auch Vertrauen. Wenn Unternehmen nachvollziehbare KI-Praktiken anwenden, vertrauen die Nutzer den Ergebnissen eher. Transparenz trägt außerdem dazu bei, Verzerrungen zu reduzieren, Verantwortlichkeit zu gewährleisten und ethische Entscheidungen zu unterstützen. Kurz gesagt: Nachvollziehbarkeit stärkt das Vertrauen sowohl in die Technologie als auch in das Unternehmen, das sie einsetzt.

Die Zukunft transparenter KI-Systeme

Da sich KI stetig weiterentwickelt, wird die Erklärbarkeit eine zentrale Rolle für ihr Wachstum spielen. Regulierungsbehörden fordern Transparenz, und Verbraucher erwarten Fairness. Unternehmen, die in erklärbare neuronale Netze investieren, erfüllen nicht nur diese Anforderungen, sondern positionieren sich auch als Vorreiter verantwortungsvoller Innovation.