لم يعد الذكاء الاصطناعي مجرد فكرة مستقبلية، بل أصبح يُشغّل تطبيقات الذكاء الاصطناعي في مختلف القطاعات. فمن تشخيص الحالات الطبية إلى التنبؤ بالمخاطر المالية، يُغيّر الذكاء الاصطناعي طريقة اتخاذ القرارات. ولكن مع ازدياد تأثير هذه الأنظمة، يبقى التحدي الأكبر: الثقة. هل يُمكننا الاعتماد على النتائج إذا لم نفهم كيفية إنتاجها؟ هنا تبرز أهمية قابلية التفسير لبناء أنظمة ذكاء اصطناعي شفافة.

لماذا تُعدّ قابلية التفسير مهمة في أنظمة الذكاء الاصطناعي الشفافة

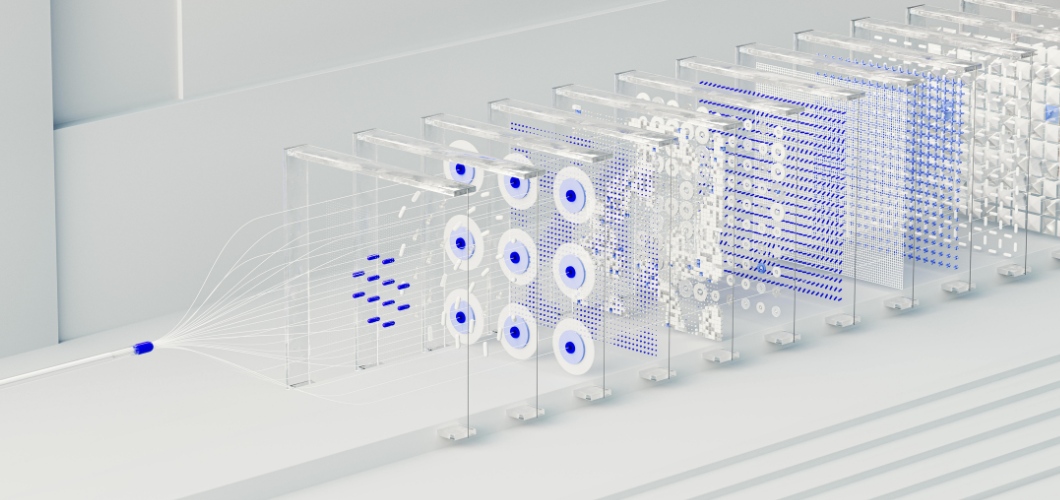

يكمن جوهر العديد من حلول الذكاء الاصطناعي المتقدمة في الشبكة العصبية، وهي نظام مُصمّم على غرار الدماغ البشري. ورغم براعة الشبكات العصبية في اكتشاف الأنماط وتقديم تنبؤات دقيقة، إلا أنها تُعتبر في كثير من الأحيان "صناديق سوداء". فنادرًا ما يعرف المستخدمون كيف يؤدي مُدخل ما إلى مُخرج مُحدد. وقد يُؤدي هذا الغموض إلى التردد، لا سيما في المجالات الحساسة كالصحة والقانون والتمويل. ولكي يكون الذكاء الاصطناعي شفافًا وأخلاقيًا، يجب إيلاء الأولوية لإمكانية التفسير.

اقرأ أيضاً: هل يقلل الفن المُولّد بالذكاء الاصطناعي من قيمة الإبداع البشري؟

استراتيجيات لتحسين قابلية تفسير الشبكات العصبية

تقنيات التصور

تُسلط أدوات مثل خرائط بروز العناصر وخرائط الحرارة الخاصة بالانتباه الضوء على نقاط البيانات التي أثرت على قرارات الشبكة العصبية، مما يوفر مزيدًا من الوضوح.

تحليل ما بعد الاختبار

تقوم طرق مثل SHAP (تفسيرات SHapley الإضافية) و LIME (التفسيرات المحلية القابلة للتفسير غير المعتمدة على النموذج) بتقسيم التنبؤات إلى عوامل مفهومة، مما يساعد المستخدمين على تتبع المخرجات.

نماذج هجينة مبسطة

إن الجمع بين الشبكات العصبية والنماذج القابلة للتفسير، مثل أشجار القرار، يسمح للشركات بتحقيق التوازن بين التعقيد وسهولة القراءة.

تتبع أهمية الميزات

من خلال تحديد المتغيرات الأكثر تأثيراً، يمكن للمؤسسات التحقق من صحة النتائج واكتشاف التحيزات المحتملة داخل تطبيقات الذكاء الاصطناعي.

بناء الثقة من خلال الشفافية

لا تقتصر أنظمة الذكاء الاصطناعي الشفافة على الامتثال للوائح فحسب، بل تتعداها إلى بناء الثقة. فعندما تتبنى الشركات ممارسات الذكاء الاصطناعي القابلة للتفسير، يشعر المستخدمون براحة أكبر في الاعتماد على النتائج. كما تُسهم الشفافية في الحد من التحيز، وتضمن المساءلة، وتدعم اتخاذ القرارات الأخلاقية. باختصار، تُعزز قابلية التفسير الثقة في كلٍ من التكنولوجيا والمؤسسة التي تستخدمها.

مستقبل أنظمة الذكاء الاصطناعي الشفافة

مع استمرار تطور الذكاء الاصطناعي، ستلعب قابلية التفسير دورًا محوريًا في نموه. يطالب المنظمون بالوضوح، ويتوقع المستهلكون العدالة. لن تفي المؤسسات التي تستثمر في الشبكات العصبية القابلة للتفسير بهذه المتطلبات فحسب، بل ستتميز أيضًا بريادتها في مجال الابتكار المسؤول.